作为一个在 SEO 行业摸爬滚打了十几年的老兵,用的各种SEO工具并不多,毕竟刚接触互联网的时候好用的工具不多,功能相对单一,巴师兄依靠累积的从计算机类期刊学习到的整合的零星知识,作为基础,大体上知道要设置什么怎么设置怎么优化。其实SEO工具也一样,把功能设计出来,给一个C/S操作界面,后台爬取网页,再跟数据库比对,再给一个固定返回值,工具的迭代无非是增加新功能,提升原有功能的兼容性。但毕竟才疏学浅,有“好用”的工具还是愿意去使用的,在这些工具里,Screaming Frog是可以推荐的工具软件之一。这款被国内 SEOers 亲切称为 “尖叫青蛙” 的爬虫工具,早已不是简单的 “查死链” 那么简单 —— 它是网站体检中心,是菜鸟技术优化的方向标,更是老鸟们藏在工具箱里的 “压箱底神器”。今天稍微聊聊,这款工具到底牛在哪,以及新手(此处新手定义)怎么快速上手。

新手:非技术小白/非建站小白,如果您此时连WordPress,网页TDK,搜索引擎蜘蛛都不明白是什么,那么此工具目前还不适合你!这篇文章是巴师兄写的,巴师兄当初见识这个工具的时候不仅仅嫌它丑,还嫌它提示死板,看起来有点难用,也没有长期留用,但在使用的过程中,工具能查漏补缺,有一定方便之处。

一、初识 Screaming Frog:为什么它是 SEOer 的 “必修课”?

第一次用 Screaming Frog 时,我差点被它 “简陋” 的界面劝退,甚至从颜值角度,觉得是个无意义的流氓工具。没有花里胡哨的仪表盘,没有自动生成的 “优化方案”,打开就是一个输入网址的搜索框,活像 2000 年代的软件。但当我输入测试网站域名后(不得不说,我拿一个不重要的站点作为测试而不是主力站点,是存在一些戒备心的),点击 “开始爬取” 后,屏幕上飞速滚动着 URL 和数据,第一印象出来了:朴实无华,返璞归真。

Screaming Frog 的核心功能,是模拟搜索引擎蜘蛛的爬取行为,把网站的每一个页面、每一条链接、每一处技术细节扒得明明白白。或许是它名字的由来:不管是寥寥几十个页面的小站,还是 10 万页的大站,它都能像青蛙捕食一样精准锁定关键信息 。

其实对于新手来说,它像一个新手村村长一样,引导并帮你避开 90% 的基础坑:比如不小心设置了 noindex 标签的首页、链向 404 页面的重要内链、标题重复到让搜索引擎懵圈的栏目页。而对老鸟来说,它是深度优化的 “显微镜”:通过分析爬取速度判断服务器响应效率,通过对比内链分布找出权重流失点,甚至能通过图片 ALT 标签的完整性评估网站的无障碍性。

二、核心功能拆解:从基础到进阶

1. 基础体检:找出网站 “致命伤”

接手一个新网站时,用 Screaming Frog 做一次全面爬取。默认设置下,它会自动检测:

- 响应码异常:404(页面不存在)、503(服务器错误)、301/302(重定向)等,红色标注的 404 页面往往是最紧急的修复项;

- 元标签问题:标题为空、标题重复、描述过短或过长,这些都会直接影响搜索引擎对页面的理解;

- 链接状态:内部链接是否有效、外部链接是否指向恶意网站、nofollow 标签是否被滥用。

举例:记得有次帮电商网站做优化,爬取后发现很多产品页的标题都是 “XXX 商城 – 优质XX”,这种重复标题标签,会大大降低搜索引擎对网站的“评分”。用 Screaming Frog 导出数据后,针对性修改了每个页面的标题,一段时间后类目流量大比例上升。

2. 进阶玩法:把爬虫变成 “数据分析利器”

Screaming Frog 不仅能查错,它的 “自定义提取” 功能才是真・黑科技。比如:

- 想统计全站 H1 标签是否唯一?用 “提取标签” 功能批量抓取 H1 内容,导出 Excel 后用数据透视表一键排查重复项;

- 想分析竞争对手的内链策略?爬取对方网站后,在 “内部链接” 报表里,能清晰看到哪些页面获得的内链最多(往往是核心流量页);

- 连 JavaScript 渲染的内容都能爬!在设置里开启 “JavaScript 渲染”,那些靠 JS 动态加载的产品信息、评论内容,再也逃不过你的眼睛。

3. 批量操作:效率提升器

老 SEO 都知道,手动检查几十个页面就够头疼了,要是遇到上百个页面的优化需求,没工具简直是灾难。Screaming Frog 的 “批量导入” 功能堪称救星:

- 把需要检查的 URL 列表导入工具,它能批量验证这些页面的状态码、标题、描述是否符合规范;

- 做 301 重定向时,用它批量核对 “旧 URL→新 URL” 的跳转是否正确,避免出现 “重定向链”(A→B→C)这种低级错误;

- 甚至能批量下载全站图片,检查 ALT 标签是否缺失 —— 对电商网站来说,这一步能直接提升图片搜索的流量。

三、老鸟私藏技巧:这些设置能让爬虫效率翻倍

多年使用Screaming Frog,总结出几个能大幅提升效率的 “骚操作”:

- 限定爬取范围:爬大站时,在 “设置→爬取” 里勾选 “只爬取子域名”,避免爬虫跑到其他无关域名浪费时间;

- 排除不必要元素:在 “设置→排除” 里添加图片、CSS、JS 的路径,让爬虫专注于 HTML 页面,速度能提升 50%;

- 自定义用户代理:有些网站会屏蔽默认爬虫,在 “设置→用户代理” 里改成 “Googlebot”,能爬取到更接近搜索引擎真实看到的内容;

- 定期对比数据:每月爬取一次网站,用 “报告→对比” 功能找出两次爬取的差异,轻松发现新增的错误页面或意外修改的标签。

四、避坑指南:这些错误新手最容易犯

虽然 Screaming Frog 上手不难,但我见过太多人因为操作不当走了弯路:

- 盲目爬取整站:刚接触时就对一个 10 万页的网站执行全量爬取,结果电脑内存爆满,爬了一半被迫中断。建议先从小范围页面开始,逐步熟悉工具;

- 忽略 “nofollow” 标签:默认设置下,爬虫会遵守 nofollow 规则,如果想查看被禁止的链接,需要在 “设置→爬取” 里取消勾选 “尊重 nofollow”;

- 忘记设置延迟:爬取小网站时,如果服务器抗压能力弱,记得在 “设置→速度” 里设置爬取延迟(比如 1000 毫秒),避免被封 IP;

- 不看 “内部链接深度”:这个数据能帮你发现 “孤岛页面”(深度超过 4 层的页面很难被搜索引擎发现),但很多人爬完就只看错误码,白白浪费了关键信息。

五、最后说句掏心窝的话

在这个 AI 工具满天飞的时代,Screaming Frog 这种 “硬核” 工具反而更显珍贵。它不会给你 “一键优化” 的幻想,却能让你实实在在地看清网站的每一寸肌理 —— 这才是 SEO 的本质:不玩虚的,只解决真问题。

如果你是刚入行的新人,花三天时间吃透它,能少走三年弯路;如果你是资深玩家,不妨重新审视下那些被忽略的功能,或许会有新的启发。毕竟,能经得起十余年行业变迁还屹立不倒的工具,自身就很硬。

下次有人问你 “SEO 有没有好用的工具”,我的答案还是一样:学会使用 Screaming Frog 再说。

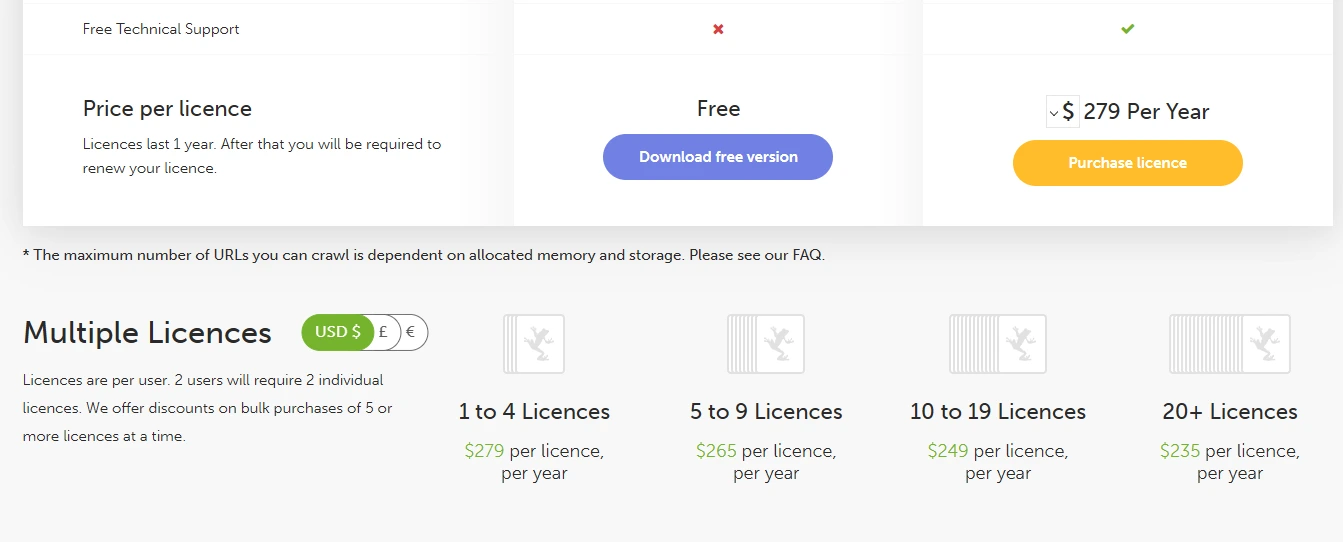

以上内容部分来源自这些年的“手记”,使用AI适当加工一下,以使描述更“规范化”。工具的用法,大家可以参考网络上的其他文章,可能在其他文章中也会有所涉及。另提一下,该工具licence价格不便宜,当想检测超500 URLs的时候,现在一年授权279美金。